科技部人文司法律學門召集人,同時也是中央研究院法律學研究所所長李建良教授,在2018年組織了一個研究團隊,結合國內關注此領域且學有專精的法律學者,共同投入「人工智慧法律問題」研究。

攝影/林俊孝

在2016年,圍棋軟體AlphaGO擊敗世界冠軍棋士李世乭之後,「人工智慧」(AI, Artificial Intellegence)這個詞,突然聲名大噪。機器擊敗了人類棋王,激發了不少或興奮、或焦慮的想像,讓許多人開始覺得,科幻小說中各種情節,其實距離並沒有那麼遙遠。

一時之間,AI成為了新的顯學。許多新產品或服務,開始標榜自己配備著聰明的人工智慧;當然,也出現一些悲劇或意外,例如自駕車的車禍,被指與AI設計不良有關。在這樣的熱度下,AI在各個面向都很有研究的空間及必要性。

科技部人文司法律學門召集人,同時也是中央研究院法律學研究所所長李建良教授,在2018年組織了一個研究團隊,結合國內關注此領域且學有專精的法律學者,共同投入「人工智慧法律問題」的研究。

AI是新玩意兒?

「當然!」應該是大部分人看到這個問題時,第一直覺浮現的答案。也難怪,畢竟是在2011年之後,大數據發展讓機器的學習能力突飛猛進,AI的進程才開始一日千里,吸引各方注目。但事實上,人工智慧真的不是新玩意兒。從1930年代末,科學家就開始思考一種可能性:既然人腦的思考,是仰賴由神經元組成的電子網絡,那是不是能讓機器也跟人一樣思考呢?

而這還不是人工智慧的起點。

在訪問正式開始前,李建良先拿出了一張像是報紙漫畫的圖片給我們看,圖中的主角,輕鬆地享受著機器提供的各種服務,仔細一瞧,卻發現這個主角,已經難以分辨,他是「人」還是「機器」。定睛細看,更令人驚訝的是報紙上的日期。

「這是一份1865年的英國畫報。」李建良說,「這麼久之前,就已經有人在探討,機器能不能像人一樣、或人會不會變成機器。」

現在我們談起AI,總帶有很多尖端科技的進步想像;但人工智慧所牽動的人性思辨與社會議題,其實早已存在於人類歷史。一百五十多年前的英國畫報,揭示的是願景?還是憂慮?

企劃腳本/黃楷元 美術設計/黃嬿羽

也許有很多技術面的進展,是跟著資訊科技的突破大步向前,然而,人工智慧作為一個社會課題,其實有很多本質上的思考,一直都存在於人類歷史中。石器時代,人類開始製作工具來改善生活;希臘神話之中,已經有人造人或機器人的故事;到了十八世紀工業革命,機器徹底改變人類生活樣貌「人 vs. 機器」引發的哲學思辨與社會問題,從來不曾休止。

所以,在人工智慧的領域,當科學家們努力在技術上做出突破、讓機器越來越聰明的時候,也必須有一群人,從人文的角度切入,思考科技發展所可能帶來的問題。

人跟機器之間,最關鍵的分別是什麼?機器越來越聰明,會不會讓人越來越懶、越來越笨?當機器跟人一樣聰明、可以自己思考做決定,我們該怎麼看待機器「人」?人類與機器之間的關係轉化,是增加倚賴與信任、還是彼此競爭敵對?……這些問題,每個都是大哉問,背後都有著深刻的哲學思維,或是牽涉到複雜的規範問題。

對於李建良來說,「人工智慧與法律規範學術研究群」的使命,就從這裡開始。

AI領域中的法律人

李建良認為,「科技人」,會走在時代的尖端,像火車頭一樣,引領著人類往前推進。但在這樣的浪潮中,「法律人」會扮演一種很獨特的角色:適時地幫這班列車減速,確保列車能穩穩當當地走在正確的軌道上。

攝影/林俊孝

李建良在法律領域的研究卓然有成,但AI人工智慧,牽涉的都是些電腦運算、數據分析、機器學習、神經網絡之類的科技專業,法律人研究AI,這麼「跳 tone」的跨界,會不會有點辛苦呢?

「與其說是有門檻要跨越,不如說,是從另外一個角度來看問題。」李建良說。

李建良認為,追求知識這件事情,最迷人的地方,是窮盡人類視野的邊界。特別是許多「科技人」,他們會走在時代的尖端,像火車頭一樣,引領著人類往前推進。但在這樣的浪潮中,「法律人」會扮演一種很獨特的角色:適時地幫這班列車減速,確保列車能穩穩當當地走在正確的軌道上。

然而,隨著普及程度增加,許多問題也開始浮現。空拍機會不會干擾飛航安全?會不會侵犯隱私?失控時會不會發生撞擊意外?法律人就必須比一般人更早、更仔細地想到這些顧慮,並且提出規範的構想與理由,讓政府據此定出合宜的法規,供人依循。

圖片來源/Pixabay

人工智慧領域也是一樣,當科技研發人員持續努力讓電腦越來越聰明、可以做的事情越來越多,法律人就必須思考,太聰明的機器,有沒有可能會產生新的問題?如果有,該怎麼預防和規範?

「法律人常常必須扮演那個比較不討喜的角色。」李建良笑說。當科技人想猛踩油門加速向前衝,法律人可能必須思考怎麼剎車。同時,因為法律規範有強制力,遭遇的反彈力道也會特別大。

但李建良也強調,很多事情並不是非黑即白、或有標準答案,大部分情況是價值選擇的問題。凡事都有正反兩面,科技可以帶來助益,也會有隱憂,權衡利弊得失之後,有時候必須暫時停下來、調整腳步再出發。學者的責任,就是把這些問題釐清,讓更多人理解,以凝聚社會共識。在這種情況下訂出的規範,才會是最多人可以接受的最大公約數。

「別誤會,法律人不是反對AI,也沒有想要拖慢科技的進展。」李建良表示,透過多面向的法律研究,可以幫人工智慧的發展預先制定出一個正確的框架,讓研發人員在好的框架下創新、廠商在正確的規範下生產製造、民眾在充分的理解下使用。有明確的標準可以依循,就能避免走冤枉路,對AI的長期發展來說絕對是加分。

人工智慧與人性尊嚴

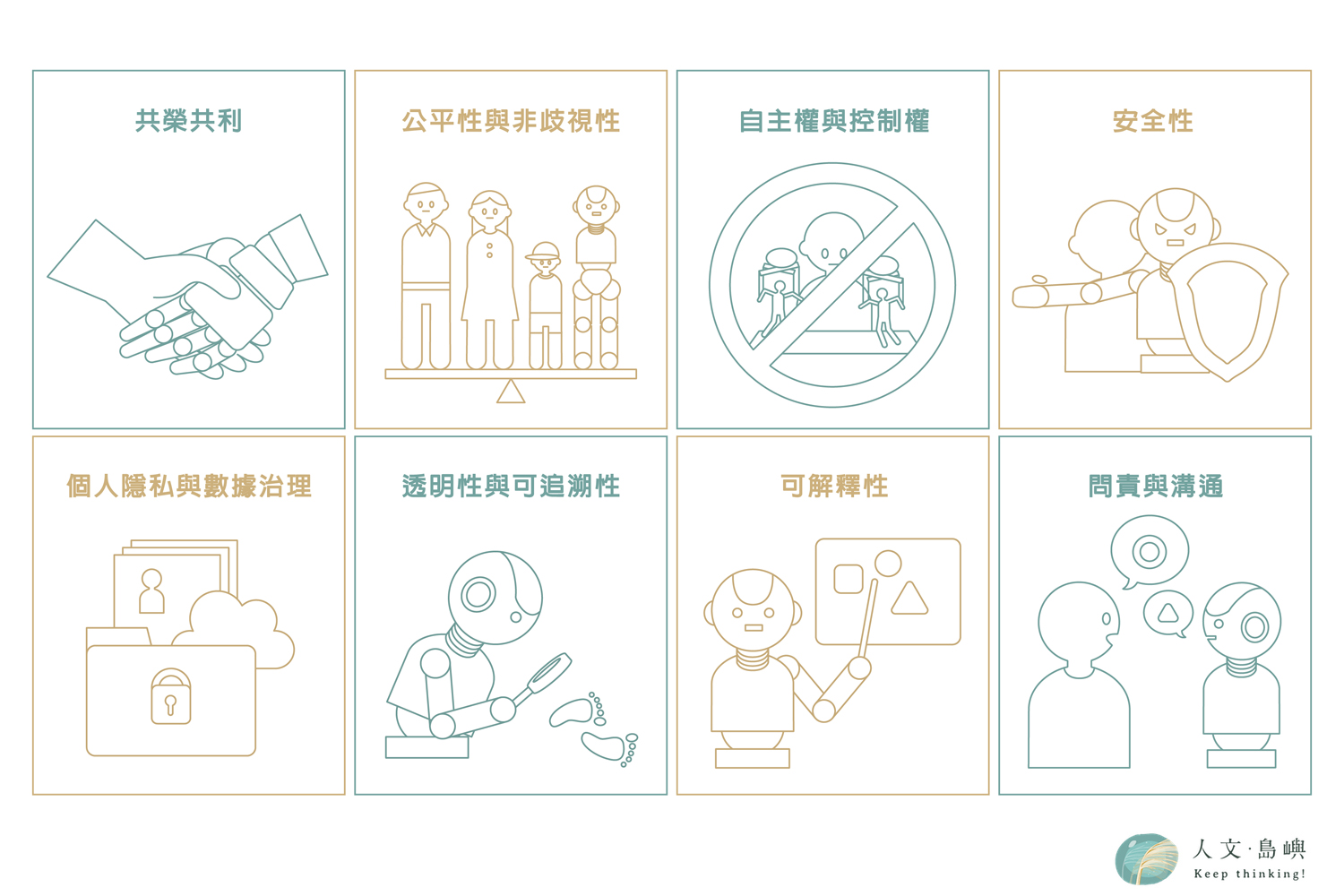

那麼,法律人究竟該給人工智慧的研究方向提供什麼樣的建議呢?科技部在2019年頒布了一份「人工智慧科研發展指引」,裡面揭示了八個目標方向,可以說是AI研究目前的官方規範指南。

八項「人工智慧科研發展指引」,是科技部2019年依據「以人為本」、「永續發展」及「多元與包容」三大核心價值所衍生,期待讓人工智慧的研究發展,能更符合普世期待。

企劃腳本/黃楷元 美術設計/黃嬿羽

從這些項目,約略可以看出,如果人工智慧真的「失控」,會在哪些面向出問題,像是侵犯隱私或洩漏個資、加深刻板印象或歧視、影響公共安全、甚至演變成政府或大企業控制人民的工具等。

這些項目每一個都很重要,李建良主持的「人工智慧與法律規範學術研究群」,就是分別從「智慧醫療」、「自動駕駛」、「金融科技」、「物聯網路」這幾個與民眾生活最相關的面向,去深入探討人工智慧可能涉及的問題與規範。

但李建良認為,最深層但也最困難的問題,可能是「人性尊嚴」。

這個「尊嚴」,並不是指「自尊心」,而是人對於自己的自主權,不會淪為他人的工具。工業化讓機器走入人類生活,工業革命從1.0到4.0,每一次的進展,都會產生新的社會問題、挑戰人性的尊嚴。

馬克思曾提出「異化」概念,批判工業社會中,人越來越脫離自己的本質,能夠掌控的事物越來越少。而在人工智慧更發達的今日,機器可以幫人處理的事情更多了,也讓這個問題出現了更複雜的發展。人工智慧讓人越來越像人,還是越來越不是人?

李建良認為,關於AI進行的思辨,其實有助於釐清這些問題。當機器越來越聰明,我們會更謹慎決定我們看待機器的方式,而在審視的過程中,機器的輪廓愈發清晰,人也能夠在自己跟機器的差別中,重新看清人的價值與定位。

李建良舉例,「安全與自由」、「理性與尊嚴」,這四種價值之間,可能存在各種競合或衝突的關係。而在人工智慧的發展中,我們應該優先確保這些價值,能夠帶來正向的回饋。「關鍵還是要回到理性的啟蒙。」李建良說。當人們越能運用理性,就越能建構一個理性的思考框架,在這框架下發展值得信賴、可靠的AI,讓人類真正能夠運用理性,活出「人」的價值。

圖片來源/Pixabay

採訪撰文/黃楷元

編輯/林俊孝

攝影/林俊孝

李建良(2019-2022)。人工智慧的創新與規範:科學技術與人文社會科學的交互作用跨領域專案計畫。科技部。

本著作由人文·島嶼著作,以創用CC 姓名標示–非商業性–禁止改作 4.0 國際 授權條款釋出。

本著作由人文·島嶼著作,以創用CC 姓名標示–非商業性–禁止改作 4.0 國際 授權條款釋出。